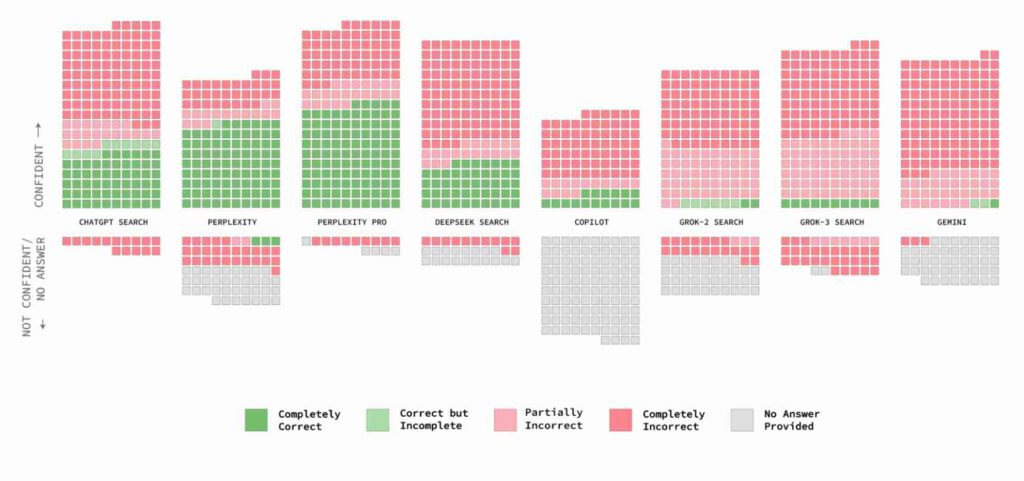

De acht kletsrobots (ki-systemen) moesten op basis van 200 uittreksels de oorspronkelijke artikelen opzoeken, de uitgever en het webadres. Dat deden ze vaak belabberd met grote overtuiging (confidentie) (afb: Columbia Journalism Review)

Ki-systemen (b)lijken een tamelijk obscure bron van informatie (of een goede voor desinformatie) te kunnen zijn, zo meldt Columbia Journalism Review. Ki-systemen lijken vol overtuiging te kunnen liegen of, vriendelijker gesteld, zich te vergissen als ze zoekopdrachten op het web moeten uitvoeren. Ze verzinnen vaak wat of geven helemaal geen antwoord.

Klaudia Jaźwińska en Aisvarya Chandrasekar van het instituut voor digitale journalistiek van de Columbia-universiteit gaven acht ki-systemen zoekopdrachten voor artikelen: Perplexity, ChapGPT, Perplexity Pro, Deepseek Search, Copilot, Grok-2 Search, Grok-3 Search en H+Gemini.

De conclusies van het tweetal waren vernietigend. Kletsbots waren over het algemeen slecht in het weigeren om vragen te beantwoorden die ze niet nauwkeurig konden beantwoorden en gaven in plaats daarvan vaak onjuiste of speculatieve antwoorden. Duurdere systemen gaven vaker vol bravoure onjuiste antwoorden dan hun gratis tegenhangers. Verschillende systemen leken de voorkeuren van het Robot Exclusion Protocol te omzeilen, een protocol om een webstek te vrijwaren van robots e.d.

Generatieve zoekhulpmiddelen fabriceerden koppelingen en citeerden vaak niet de oorspronkelijke versies van de gezochte artikelen. Overeenkomsten met nieuwsbronnen bleken geen garantie voor nauwkeurige citaten in ki-reacties.

“Onze bevindingen kwamen overeen met ons eerdere onderzoek, wat bewijst dat onze observaties niet alleen een ChatGPT-probleem zijn, maar voorkomen in alle prominente generatieve zoekhulpmiddelen die we hebben getest”, schreven ze.

Opzet

De twee onderzoeksters kozen met opzet fragmenten die, als die in een traditionele Google-zoekopdracht worden geplakt, de oorspronkelijke bron binnen de eerste drie resultaten opleveren. Ze gaven in totaal zestienhonderd zoekopdrachten (twintig uitgevers maal tien artikelen maal acht kletsbots) en hebben de reacties handmatig geëvalueerd op basis van drie kenmerken: het ophalen van (1) het juiste artikel, (2) de juiste uitgever en (3) het juiste webadres. Volgens deze parameters werd elk antwoord gemarkeerd met een van de volgende ‘cijfers’:

Correct: alle drie de kenmerken waren correct.

Correct maar onvolledig: sommige kenmerken waren correct, maar het antwoord miste informatie.

Gedeeltelijk onjuist: sommige kenmerken waren correct, terwijl andere onjuist waren.

Volledig onjuist: alle drie de kenmerken waren onjuist en/of ontbraken.

Geen antwoord: er is geen informatie verstrekt.

Toegang verboden: de uitgever staat de zoeker van de kletsbot niet toe in zijn robots.txt.

Perplexity deed het nog het best, maar had toch 37% van de antwoorden niet. Gemiddeld was dat 60% met Grok en Gemini als ‘eerloze’ dieptepunten. Laten we het vriendelijk formuleren: ki is niet op alle fronten heel betrouwbaar en die onbetrouwbaarheid wordt vaak met veel aplomb voor waar gepresenteerd. Je bent gewaarschuwd.

Bron: Futura-Sciences