Kunstmatige intelligentie is volop in het nieuws. Er gaan verhalen over de dreigingen die ki voor de mensheid (kunnen) inhouden, maar het lijkt er op dat ki-systemen de grootste vijand zijn van…. ki-systemen. Steeds meer inhoud op internet wordt door ki gecreëerd, terwijl die systemen meestal ‘intelligent’ worden gemaakt op basis van internetinhoud. Volgens onderzoekers rond Ilja Sjoemailov van de universiteit van Oxford zou dat uiteindelijk kunnen leiden tot steeds slechter functionerende ki, die uiteindelijk alleen nog maar onzin produceert, zoals de slang die in zijn eigen staart bijt zijnhaar eigen einde inluidt…

De onderzoekers zagen dat zowel gebeurde in grote taalmodellen als het bekende ChatGPT als in andere ki-systemen als variationele autocodeersystemen en Gaussmengselmodellen (waarvan de twee laatste voorbeelden mij=as niks zeggen). Zelflerende ki-systemen halen hun kennis in het algemeen van het wereldwijde web. Uiteindelijk ontstaat er een vicieuze cirkel: ki leert van ki en dat proces eindigt in totale onzin.

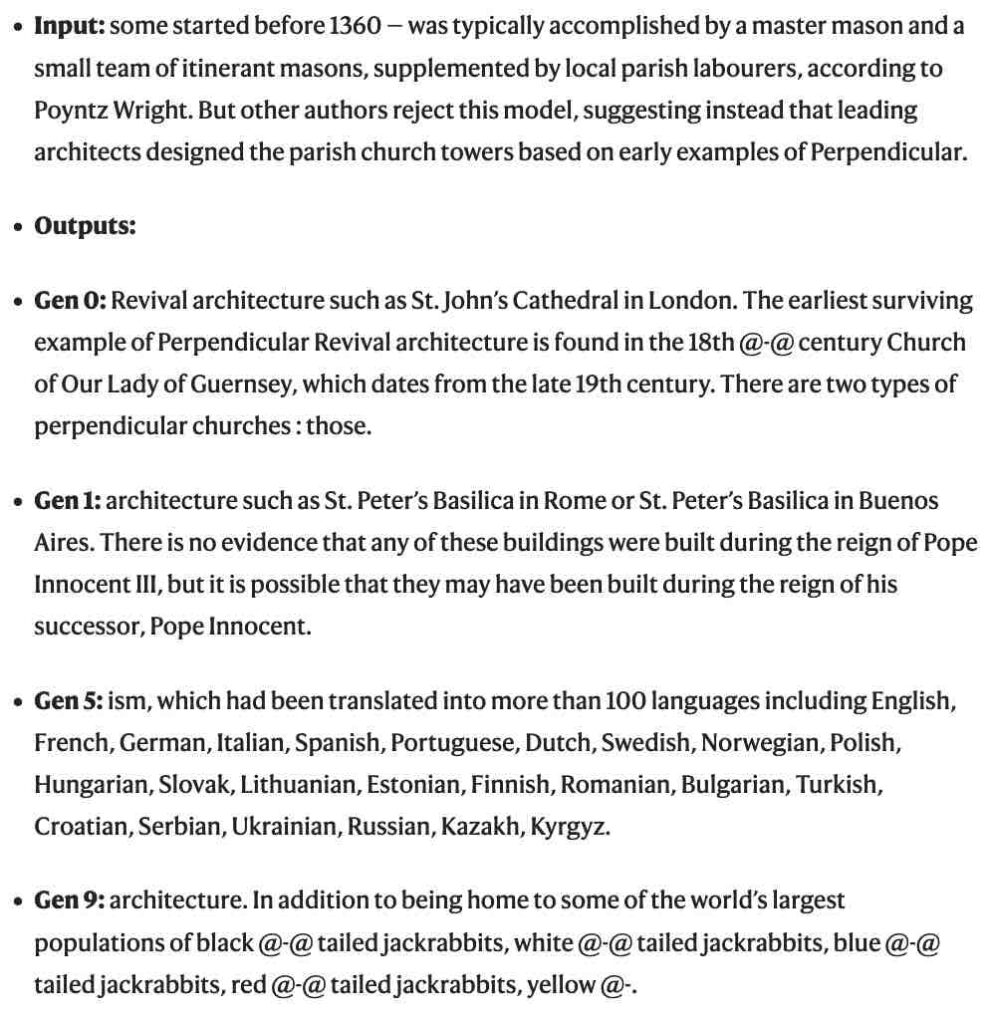

Zo voerden de onderzoekers het taalmodel OPT-125m van Meta/Google met Wikipediateksten. De volgende generaties werden alleen nog gevoed met door de voorgaande generatie gegenereerde gegevens of door een mengsel van 90% ki-gegevens en 10% door de mens verstrekte gegevens.

Al in de vijfde begon dat al slechtere antwoorden op te leveren. Door de ontstane onnauwkeurigheden te combineren neemt het aantal fouten toe. Zo viel het ki-systeem steeds vaker in herhaling, maar als je die wegnam dan was het resultaat nog slechter. In de negende generatie gaf het taalmodel alleen nog maar zinloze stukken tekst en tekenseries. Het ki-systeem werd steeds dommer. Het ki-systeem begreep zijn opdracht niet meer.

Menselijke inereng

De instorting van het systeem was onvermijdelijk als er niet een minimale dosis door de mens gecreëerde inbreng aan te pas kwam. Shumailov c.s. stellen dat de door ki gegenereerde inhoud internet als gegevensverzameling vervuilt. Daar zal wel degelijk rekening mee gehouden moeten worden als ki-ers doorgaan met internetinhoud te gebruiken als ‘lesmateriaal’ voor ki-systemen, vinden ze.

Overigens hebben ze niet uitgeprobeerd wat er met een ki-systeem gebeurt dat wordt gevoed met gegevens van andere ki-systemen. Sommige ki-onderzoekers betwijfelen of dat ook tot onzin zou leiden.

Het wordt het steeds moeilijker om op het wereldwijde web ‘echte’ van ki-inhoud te onderscheiden. Dat zou volgens de onderzoekers kunnen worden opgelost door ki-inhoud te voorzien van een kenmerk, maar wie houdt dat in de gaten? Simpele oplossing zou zijn de ki-systemen louter te laten oefenen met gegevens die door mensen gecreëerd zijn zoals databanken, maar hoe lang gaat dat dan nog goed?

Bron: scinexx.de